Всем привет. В преддверии старта новой группы курса публикуем полезный материал, написанный нашим студентом, а также наставником на курсах, специалистом технической поддержки корпоративных продуктов REG.RU — Романом Травиным.

В данной статье будет рассмотрены 2 случая замены дисков и переноса информации на новые диски большего объёма с дальнейшим расширением массива и файловой системы. Первый случай будет касаться замены дисков c одноименной разметкой MBR/MBR либо GPT/GPT, второй случай касается замены дисков с разметкой MBR на диски объёмом более 2 TB, на которые потребуется ставить разметку GPT с разделом biosboot. В обоих случаях диски, на которые переносим данным, уже установлены в сервер. Файловая система, используемая для корневого раздела — ext4.

Случай 1: Замена дисков меньшего объёма на диски большего объёма (до 2TB)

Задача: Заменить текущие диски на диски большего объёма (до 2 TB) с переносом информации. В данном случае имеем диски 2 x 240 GB SSD (RAID-1) с установленной системой и диски 2 x 1 TB SATA, на которые необходимо перенести систему.

Рассмотрим текущую разметку дисков.

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

├─sda1 8:1 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sda2 8:2 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdb 8:16 0 223,6G 0 disk

├─sdb1 8:17 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdb2 8:18 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdc 8:32 0 931,5G 0 disk

sdd 8:48 0 931,5G 0 disk Проверим используемое пространство файловой системы на данный момент.

[root@localhost ~]# df -h

Файловая система Размер Использовано Дост Использовано% Cмонтировано в

devtmpfs 32G 0 32G 0% /dev

tmpfs 32G 0 32G 0% /dev/shm

tmpfs 32G 9,6M 32G 1% /run

tmpfs 32G 0 32G 0% /sys/fs/cgroup

/dev/mapper/vg0-root 204G 1,3G 192G 1% /

/dev/md126 1007M 120M 837M 13% /boot

tmpfs 6,3G 0 6,3G 0% /run/user/0 Размер файловой системы до замены дисков составляет 204 GB, используются 2 программных массива md126, который смонтирован в /boot и md127, который используется как physical volume для VG группы vg0.

1. Удаление разделов диска из массивов

Проверям состояние массива

[root@localhost ~]# cat /proc/mdstat

Personalities : [raid1]

md126 : active raid1 sda1[0] sdb1[1]

1047552 blocks super 1.2 [2/2] [UU]

bitmap: 0/1 pages [0KB], 65536KB chunk

md127 : active raid1 sda2[0] sdb2[1]

233206784 blocks super 1.2 [2/2] [UU]

bitmap: 0/2 pages [0KB], 65536KB chunk

unused devices: <none> В системе используется 2 массива: md126 (точка монтирования /boot) — состоит из раздела /dev/sda1 и /dev/sdb1, md127 (LVM для swap и корня файловой системы) — состоит из /dev/sda2 и /dev/sdb2.

Помечаем разделы первого диска, которые используются в каждом массиве, как сбойные.

mdadm /dev/md126 --fail /dev/sda1

mdadm /dev/md127 --fail /dev/sda2

Удаляем разделы блочного устройства /dev/sda из массивов.

mdadm /dev/md126 --remove /dev/sda1

mdadm /dev/md127 --remove /dev/sda2После того, как мы удалили диск из массива, информация о блочных устройствах будет выглядеть следующим образом.

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

├─sda1 8:1 0 1G 0 part

└─sda2 8:2 0 222,5G 0 part

sdb 8:16 0 223,6G 0 disk

├─sdb1 8:17 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdb2 8:18 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdc 8:32 0 931,5G 0 disk

sdd 8:48 0 931,5G 0 disk Состояние массивов после удаления дисков.

[root@localhost ~]# cat /proc/mdstat

Personalities : [raid1]

md126 : active raid1 sdb1[1]

1047552 blocks super 1.2 [2/1] [_U]

bitmap: 0/1 pages [0KB], 65536KB chunk

md127 : active raid1 sdb2[1]

233206784 blocks super 1.2 [2/1] [_U]

bitmap: 1/2 pages [4KB], 65536KB chunk

unused devices: <none>2. Копирование таблицы разделов на новый диск

Проверить используемую таблицу разделов на диске можно следующей командой.

fdisk -l /dev/sdb | grep 'Disk label type'

Выводом для MBR будет:

Disk label type: dosдля GPT:

Disk label type: gpt Копирование таблицы разметки для MBR:

sfdisk -d /dev/sdb | sfdisk /dev/sdcВ данной команде первым указывается диск с которого копируется разметка, вторым — куда копировать.

ВНИМАНИЕ: Для GPT первым указывается диск на который копировать разметку, вторым диском указывается диск с которого копировать разметку. Если перепутать диски, то изначально исправная разметка будет перезаписана и уничтожена.

Копирование таблицы разметки для GPT:

sgdisk -R /dev/sdс /dev/sdbДалее назначаем диску случайный UUID (для GPT).

sgdisk -G /dev/sdc После выполненной команды разделы должны появится на диске /dev/sdc.

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

├─sda1 8:1 0 1G 0 part

└─sda2 8:2 0 222,5G 0 part

sdb 8:16 0 223,6G 0 disk

├─sdb1 8:17 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdb2 8:18 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdc 8:32 0 931,5G 0 disk

├─sdc1 8:33 0 1G 0 part

└─sdc2 8:34 0 222,5G 0 part

sdd 8:48 0 931,5G 0 disk Если после выполненного действия разделы в системе на диске /dev/sdc не определились, то выполняем команду, чтобы перечитать таблицу разделов.

sfdisk -R /dev/sdcЕсли на текущих дисках используется таблица MBR и информацию необходимо перенести на диски объёмом более 2 TB, то на новых дисках потребуется вручную создавать разметку GPT с использованием раздела biosboot. Данный случай будет рассмотрен во 2 части данной статьи.

3. Добавление разделов нового диска в массив

Добавим разделы диска в соответствующие массивы.

mdadm /dev/md126 --add /dev/sdc1

mdadm /dev/md127 --add /dev/sdc2Проверяем, что разделы добавлены.

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

├─sda1 8:1 0 1G 0 part

└─sda2 8:2 0 222,5G 0 part

sdb 8:16 0 223,6G 0 disk

├─sdb1 8:17 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdb2 8:18 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdc 8:32 0 931,5G 0 disk

├─sdc1 8:33 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdc2 8:34 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdd 8:48 0 931,5G 0 disk После этого дожидаемся синхронизации массивов.

[root@localhost ~]# cat /proc/mdstat

Personalities : [raid1]

md126 : active raid1 sdc1[2] sdb1[1]

1047552 blocks super 1.2 [2/2] [UU]

bitmap: 0/1 pages [0KB], 65536KB chunk

md127 : active raid1 sdc2[2] sdb2[1]

233206784 blocks super 1.2 [2/1] [_U]

[==>..................] recovery = 10.6% (24859136/233206784) finish=29.3min speed=118119K/sec

bitmap: 2/2 pages [8KB], 65536KB chunk

unused devices: <none> Непрерывно наблюдать за процессом синхронизации можно с помощью утилиты watch.

watch -n 2 cat /proc/mdstat Параметр -n указывает с каким интервалов в секундах необходимо выполнять команду для проверки прогресса.

Повторяем пункты 1 — 3 для следующего заменяемого диска.

Помечаем разделы второго диска, которые используются в каждом массиве, как сбойные.

mdadm /dev/md126 --fail /dev/sdb1

mdadm /dev/md127 --fail /dev/sdb2

Удаляем разделы блочного устройства /dev/sdb из массивов.

mdadm /dev/md126 --remove /dev/sdb1

mdadm /dev/md127 --remove /dev/sdb2После того, как мы удалили диск из массива, информация о блочных устройствах будет выглядеть следующим образом.

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

├─sda1 8:1 0 1G 0 part

└─sda2 8:2 0 222,5G 0 part

sdb 8:16 0 223,6G 0 disk

├─sdb1 8:17 0 1G 0 part

└─sdb2 8:18 0 222,5G 0 part

sdc 8:32 0 931,5G 0 disk

├─sdc1 8:33 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdc2 8:34 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdd 8:48 0 931,5G 0 disk

Состояние массивов после удаления дисков.

[root@localhost ~]# cat /proc/mdstat

Personalities : [raid1]

md126 : active raid1 sdc1[2]

1047552 blocks super 1.2 [2/1] [U_]

bitmap: 0/1 pages [0KB], 65536KB chunk

md127 : active raid1 sdc2[2]

233206784 blocks super 1.2 [2/1] [U_]

bitmap: 1/2 pages [4KB], 65536KB chunk

unused devices: <none> Копируем таблицу разметки MBR с диска /dev/sdс на диск /dev/sdd.

sfdisk -d /dev/sdс | sfdisk /dev/sdd После выполненной команды разделы должны появится на диске /dev/sdd.

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

├─sda1 8:1 0 1G 0 part

└─sda2 8:2 0 222,5G 0 part

sdb 8:16 0 223,6G 0 disk

├─sdb1 8:17 0 1G 0 part

└─sdb2 8:18 0 222,5G 0 part

sdc 8:32 0 931,5G 0 disk

├─sdc1 8:33 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdc2 8:34 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdd 8:48 0 931,5G 0 disk

├─sdd1 8:49 0 1G 0 part

└─sdd2 8:50 0 222,5G 0 part Добавляем разделы диска в массивы.

mdadm /dev/md126 --add /dev/sdd1

mdadm /dev/md127 --add /dev/sdd2Проверяем, что разделы добавлены.

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

├─sda1 8:1 0 1G 0 part

└─sda2 8:2 0 222,5G 0 part

sdb 8:16 0 223,6G 0 disk

├─sdb1 8:17 0 1G 0 part

└─sdb2 8:18 0 222,5G 0 part

sdc 8:32 0 931,5G 0 disk

├─sdc1 8:33 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdc2 8:34 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdd 8:48 0 931,5G 0 disk

├─sdd1 8:49 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdd2 8:50 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]После этого дожидаемся синхронизации массивов.

[root@localhost ~]# cat /proc/mdstat

Personalities : [raid1]

md126 : active raid1 sdd1[3] sdc1[2]

1047552 blocks super 1.2 [2/2] [UU]

bitmap: 0/1 pages [0KB], 65536KB chunk

md127 : active raid1 sdd2[3] sdc2[2]

233206784 blocks super 1.2 [2/1] [U_]

[>....................] recovery = 0.5% (1200000/233206784) finish=35.4min speed=109090K/sec

bitmap: 2/2 pages [8KB], 65536KB chunk

unused devices: <none>

5. Установка GRUB на новые диски

Для CentOS:

grub2-install /dev/sdXДля Debian/Ubuntu:

grub-install /dev/sdX где X — буква блочного устройства. В данном случае установить GRUB необходимо на /dev/sdc и /dev/sdd.

6. Расширение файловой системы (ext4) корневого раздела

На новых дисках /dev/sdc и /dev/sdd доступны 931.5 GB. Из-за того, что таблица разделов скопирована с дисков меньшего объёма, на разделах /dev/sdc2 и /dev/sdd2 доступны 222.5 GB.

sdc 8:32 0 931,5G 0 disk

├─sdc1 8:33 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdc2 8:34 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdd 8:48 0 931,5G 0 disk

├─sdd1 8:49 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdd2 8:50 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]Необходимо:

- Расширить раздел 2 на каждом из дисков,

- Расширить массив md127,

- Расширить PV (physical volume),

- Расширить LV (logical-volume) vg0-root,

- Расширить файловую систему.

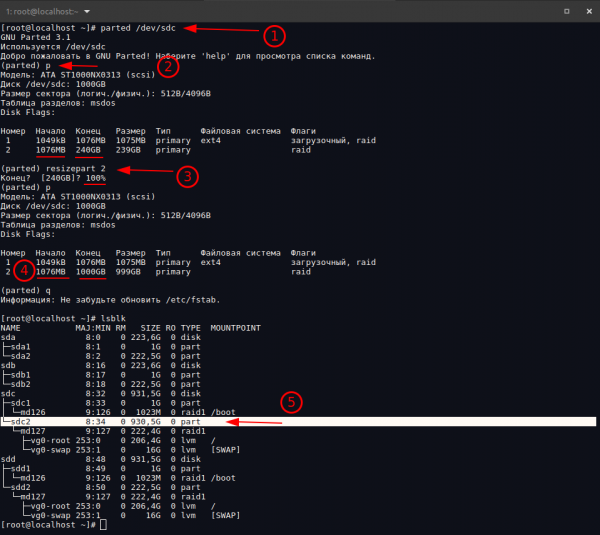

Используя утилиту parted расширим раздел /dev/sdc2 до максимального значения. Выполняем команду parted /dev/sdc (1) и просматриваем текущую таблицу разделов командой p (2).

Как видно, конец раздела 2 заканчивается на 240 GB. Выполним расширение раздела командой resizepart 2, где 2 — номер раздела (3). Указываем значение в цифровом формате, например 1000 GB, или используем указание доли диска — 100%. Снова проверяем, что раздел имеет новый размер (4).

Повторяем указанные выше действия для диска /dev/sdd. После расширения разделов /dev/sdc2 и /dev/sdd2 стали равными 930.5 GB.

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

├─sda1 8:1 0 1G 0 part

└─sda2 8:2 0 222,5G 0 part

sdb 8:16 0 223,6G 0 disk

├─sdb1 8:17 0 1G 0 part

└─sdb2 8:18 0 222,5G 0 part

sdc 8:32 0 931,5G 0 disk

├─sdc1 8:33 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdc2 8:34 0 930,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdd 8:48 0 931,5G 0 disk

├─sdd1 8:49 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdd2 8:50 0 930,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]После этого выполняем расширение массива md127 до максимума.

mdadm --grow /dev/md127 --size=maxПроверяем, что массив расширился. Теперь его размер стал 930.4 GB.

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

├─sda1 8:1 0 1G 0 part

└─sda2 8:2 0 222,5G 0 part

sdb 8:16 0 223,6G 0 disk

├─sdb1 8:17 0 1G 0 part

└─sdb2 8:18 0 222,5G 0 part

sdc 8:32 0 931,5G 0 disk

├─sdc1 8:33 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdc2 8:34 0 930,5G 0 part

└─md127 9:127 0 930,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdd 8:48 0 931,5G 0 disk

├─sdd1 8:49 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdd2 8:50 0 930,5G 0 part

└─md127 9:127 0 930,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]Выполняем расширение physical volume. Перед расширением проверим текущее состояние PV.

[root@localhost ~]# pvscan

PV /dev/md127 VG vg0 lvm2 [222,40 GiB / 0 free]

Total: 1 [222,40 GiB] / in use: 1 [222,40 GiB] / in no VG: 0 [0 ]

Как видно, PV /dev/md127 использует 222.4 GB пространства.

Расширяем PV следующей командой.

pvresize /dev/md127Проверяем результат расширения PV.

[root@localhost ~]# pvscan

PV /dev/md127 VG vg0 lvm2 [930,38 GiB / 707,98 GiB free]

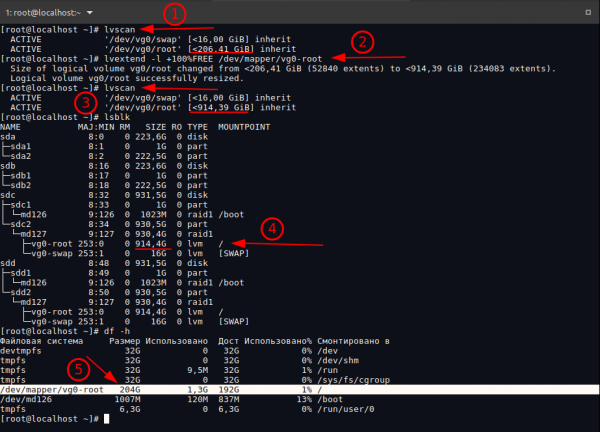

Total: 1 [930,38 GiB] / in use: 1 [930,38 GiB] / in no VG: 0 [0 ]Расширяем logical volume. Перед расширением проверим текущее состояние LV (1).

[root@localhost ~]# lvscan

ACTIVE '/dev/vg0/swap' [<16,00 GiB] inherit

ACTIVE '/dev/vg0/root' [<206,41 GiB] inherit LV /dev/vg0/root использует 206.41 GB.

Расширяем LV следующей командой (2).

lvextend -l +100%FREE /dev/mapper/vg0-rootПроверяем выполненное действие (3).

[root@localhost ~]# lvscan

ACTIVE '/dev/vg0/swap' [<16,00 GiB] inherit

ACTIVE '/dev/vg0/root' [<914,39 GiB] inherit

Как видим, после расширения LV объём занимаемого дискового пространства стал 914.39 GB.

Объём LV увеличился (4), но файловая система по прежнему занимает 204 GB (5).

1. Выполним расширение файловой системы.

resize2fs /dev/mapper/vg0-rootПроверяем после выполненной команды размер файловой системы.

[root@localhost ~]# df -h

Файловая система Размер Использовано Дост Использовано% Cмонтировано в

devtmpfs 32G 0 32G 0% /dev

tmpfs 32G 0 32G 0% /dev/shm

tmpfs 32G 9,5M 32G 1% /run

tmpfs 32G 0 32G 0% /sys/fs/cgroup

/dev/mapper/vg0-root 900G 1,3G 860G 1% /

/dev/md126 1007M 120M 837M 13% /boot

tmpfs 6,3G 0 6,3G 0% /run/user/0Размер корневой файловой системы увеличится до 900 GB. После выполненных действий можно извлекать старые диски.

Случай 2: Замена дисков меньшего объёма на диски большего объёма (более 2TB)

Задание: Заменить текущие диски на диски большего объёма (2 x 3TB) с сохранением информации. В данном случае имеем диски 2 x 240 GB SSD (RAID-1) с установленной системой и диски 2 x 3 TB SATA, на которые необходимо перенести систему. На текущих дисках используется таблица разделов MBR. Так как новые диски имеют объём больше 2 TB, то на них потребуется использовать таблицу GPT, так как MBR не может работать с дисками более 2TB.

Просмотрим текущую разметку дисков.

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

├─sda1 8:1 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sda2 8:2 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdb 8:16 0 223,6G 0 disk

├─sdb1 8:17 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdb2 8:18 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdc 8:32 0 2,7T 0 disk

sdd 8:48 0 2,7T 0 disk Проверим используемую таблицу разделов на диске /dev/sda.

[root@localhost ~]# fdisk -l /dev/sda | grep 'Disk label type'

Disk label type: dos На диске /dev/sdb используется аналогичная таблица разделов. Проверим используемое дисковое пространство в системе.

[root@localhost ~]# df -h

Файловая система Размер Использовано Дост Использовано% Cмонтировано в

devtmpfs 16G 0 16G 0% /dev

tmpfs 16G 0 16G 0% /dev/shm

tmpfs 16G 9,5M 16G 1% /run

tmpfs 16G 0 16G 0% /sys/fs/cgroup

/dev/mapper/vg0-root 204G 1,3G 192G 1% /

/dev/md126 1007M 120M 837M 13% /boot

tmpfs 3,2G 0 3,2G 0% /run/user/0Как видно, корень файловой системы занимает 204 GB. Проверим текущее состояние программного RAID-массива.

1. Установка GPT таблицы разделов и разметка диска

Проверим разметку дисков по секторам.

[root@localhost ~]# parted /dev/sda print

Модель: ATA KINGSTON SVP200S (scsi)

Диск /dev/sda: 240GB

Размер сектора (логич./физич.): 512B/512B

Таблица разделов: msdos

Disk Flags:

Номер Начало Конец Размер Тип Файловая система Флаги

1 1049kB 1076MB 1075MB primary загрузочный, raid

2 1076MB 240GB 239GB primary raid

На новом диске 3TB нам необходимо будет создать 3 раздела:

- Раздел

bios_grubразмером 2MiB для совместимости GPT с BIOS, - Раздел для RAID массива, который будет смонтирован в

/boot. - Раздел для RAID-массива, на котором будет LV root и LV swap.

Устанавливаем утилиту parted командой yum install -y parted (для CentOS), apt install -y parted (для Debian/Ubuntu).

Используя parted выполним следующие команды для разметки диска.

Выполняем команду parted /dev/sdc и переходим в режим редактирования разметки диска.

Создаём таблицу разделов GPT.

(parted) mktable gpt Создаём 1 раздел bios_grub раздел и устанавливаем флаг для него.

(parted) mkpart primary 1MiB 3MiB

(parted) set 1 bios_grub on Создаём 2 раздел и устанавливаем флаг для него. Раздел будет использовать в качестве блока для RAID-массива и монтирования его в /boot.

(parted) mkpart primary ext2 3MiB 1028MiB

(parted) set 2 boot onСоздаём 3 раздел, который также будет использоваться в качестве блока массива, в котором будет LVM.

(parted) mkpart primary 1028MiB 100% В данном случае устанавливать флаг не обязательно, но если необходимо, то возможно его установить следующей командой.

(parted) set 3 raid onПроверяем созданную таблицу.

(parted) p

Модель: ATA TOSHIBA DT01ACA3 (scsi)

Диск /dev/sdc: 3001GB

Размер сектора (логич./физич.): 512B/4096B

Таблица разделов: gpt

Disk Flags:

Номер Начало Конец Размер Файловая система Имя Флаги

1 1049kB 3146kB 2097kB primary bios_grub

2 3146kB 1077MB 1074MB primary загрузочный

3 1077MB 3001GB 3000GB primary

Назначаем диску новый случайный GUID.

sgdisk -G /dev/sdd

2. Удаление разделов первого диска из массивов

Проверям состояние массива

[root@localhost ~]# cat /proc/mdstat

Personalities : [raid1]

md126 : active raid1 sda1[0] sdb1[1]

1047552 blocks super 1.2 [2/2] [UU]

bitmap: 0/1 pages [0KB], 65536KB chunk

md127 : active raid1 sda2[0] sdb2[1]

233206784 blocks super 1.2 [2/2] [UU]

bitmap: 0/2 pages [0KB], 65536KB chunk

unused devices: <none> В системе используется 2 массива: md126 (точка монтирования /boot) — состоит из /dev/sda1 и /dev/sdb1, md127 (LVM для swap и корня файловой системы) — состоит из /dev/sda2 и /dev/sdb2.

Помечаем разделы первого диска, которые используются в каждом массиве, как сбойные.

mdadm /dev/md126 --fail /dev/sda1

mdadm /dev/md127 --fail /dev/sda2 Удаляем разделы блочного устройства /dev/sda из массивов.

mdadm /dev/md126 --remove /dev/sda1

mdadm /dev/md127 --remove /dev/sda2

Проверяем состояние массива после удаления диска.

[root@localhost ~]# cat /proc/mdstat

Personalities : [raid1]

md126 : active raid1 sdb1[1]

1047552 blocks super 1.2 [2/1] [_U]

bitmap: 0/1 pages [0KB], 65536KB chunk

md127 : active raid1 sdb2[1]

233206784 blocks super 1.2 [2/1] [_U]

bitmap: 2/2 pages [8KB], 65536KB chunk

unused devices: <none>

3. Добавление разделов нового диска в массив

Следующим шагом необходимо добавить разделы нового диска в массивы для синхронизации. Смотрим текущее состояние разметки дисков.

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

├─sda1 8:1 0 1G 0 part

└─sda2 8:2 0 222,5G 0 part

sdb 8:16 0 223,6G 0 disk

├─sdb1 8:17 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdb2 8:18 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdc 8:32 0 2,7T 0 disk

├─sdc1 8:33 0 2M 0 part

├─sdc2 8:34 0 1G 0 part

└─sdc3 8:35 0 2,7T 0 part

sdd 8:48 0 2,7T 0 disk Раздел /dev/sdc1 является bios_grub разделом и не участвует с создании массивов. В массивах будут задействованы только /dev/sdc2 и /dev/sdc3. Добавляем данные разделы в соответствующие массивы.

mdadm /dev/md126 --add /dev/sdc2

mdadm /dev/md127 --add /dev/sdc3После чего дожидаемся синхронизации массива.

[root@localhost ~]# cat /proc/mdstat

Personalities : [raid1]

md126 : active raid1 sdc2[2] sdb1[1]

1047552 blocks super 1.2 [2/2] [UU]

bitmap: 0/1 pages [0KB], 65536KB chunk

md127 : active raid1 sdc3[2] sdb2[1]

233206784 blocks super 1.2 [2/1] [_U]

[>....................] recovery = 0.2% (619904/233206784) finish=31.2min speed=123980K/sec

bitmap: 2/2 pages [8KB], 65536KB chunk

unused devices: <none>Разметка дисков после добавления разделов в массив.

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

├─sda1 8:1 0 1G 0 part

└─sda2 8:2 0 222,5G 0 part

sdb 8:16 0 223,6G 0 disk

├─sdb1 8:17 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdb2 8:18 0 222,5G 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdc 8:32 0 2,7T 0 disk

├─sdc1 8:33 0 2M 0 part

├─sdc2 8:34 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdc3 8:35 0 2,7T 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdd 8:48 0 2,7T 0 disk 4. Удаление разделов второго диска из массивов

Помечаем разделы второго диска, которые используются в каждом массиве, как сбойные.

mdadm /dev/md126 --fail /dev/sdb1

mdadm /dev/md127 --fail /dev/sdb2

Удаляем разделы блочного устройства /dev/sda из массивов.

mdadm /dev/md126 --remove /dev/sdb1

mdadm /dev/md127 --remove /dev/sdb2

5. Копируем таблицу разметки GPT и синхронизируем массив

Для копирования таблицы разметки GPT воспользуемся утилитой sgdisk, которая входит в пакет для работы с разделами дисков и таблицей GPT — gdisk.

Установка gdisk для CentOS:

yum install -y gdisk Установка gdisk для Debian/Ubuntu:

apt install -y gdiskВНИМАНИЕ: Для GPT первым указывается диск на который копируем разметку, вторым диском указывается диск с которого копируют разметку. Если перепутать диски, то изначально исправная разметка будет перезаписана и уничтожена.

Копируем таблицу разметки GPT.

sgdisk -R /dev/sdd /dev/sdc Разметка дисков после переноса таблицы на диск /dev/sdd.

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

├─sda1 8:1 0 1G 0 part

└─sda2 8:2 0 222,5G 0 part

sdb 8:16 0 223,6G 0 disk

├─sdb1 8:17 0 1G 0 part

└─sdb2 8:18 0 222,5G 0 part

sdc 8:32 0 2,7T 0 disk

├─sdc1 8:33 0 2M 0 part

├─sdc2 8:34 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdc3 8:35 0 2,7T 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdd 8:48 0 2,7T 0 disk

├─sdd1 8:49 0 2M 0 part

├─sdd2 8:50 0 1G 0 part

└─sdd3 8:51 0 2,7T 0 part Далее добавляем каждый из разделов, участвующих в программных RAID-массивах.

mdadm /dev/md126 --add /dev/sdd2

mdadm /dev/md127 --add /dev/sdd3Дожидаемся синхронизации массива.

[root@localhost ~]# cat /proc/mdstat

Personalities : [raid1]

md126 : active raid1 sdd2[3] sdc2[2]

1047552 blocks super 1.2 [2/2] [UU]

bitmap: 1/1 pages [4KB], 65536KB chunk

md127 : active raid1 sdd3[3] sdc3[2]

233206784 blocks super 1.2 [2/1] [U_]

[>....................] recovery = 0.0% (148224/233206784) finish=26.2min speed=148224K/sec

bitmap: 2/2 pages [8KB], 65536KB chunk

unused devices: <none>После копирования разметки GPT на второй новый диск, разметка будет выглядеть следующим образом.

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

├─sda1 8:1 0 1G 0 part

└─sda2 8:2 0 222,5G 0 part

sdb 8:16 0 223,6G 0 disk

├─sdb1 8:17 0 1G 0 part

└─sdb2 8:18 0 222,5G 0 part

sdc 8:32 0 2,7T 0 disk

├─sdc1 8:33 0 2M 0 part

├─sdc2 8:34 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdc3 8:35 0 2,7T 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdd 8:48 0 2,7T 0 disk

├─sdd1 8:49 0 2M 0 part

├─sdd2 8:50 0 1G 0 part

│ └─md126 9:126 0 1023M 0 raid1 /boot

└─sdd3 8:51 0 2,7T 0 part

└─md127 9:127 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]Далее устанавливаем GRUB на новые диски.

Установка для CentOS:

grub2-install /dev/sdXУстановка для Debian/Ubuntu:

grub-install /dev/sdX где X — буква диска, в нашем случае диски /dev/sdc и /dev/sdd.

Обновляем информацию о массиве.

Для CentOS:

mdadm --detail --scan --verbose > /etc/mdadm.confДля Debian/Ubuntu:

echo "DEVICE partitions" > /etc/mdadm/mdadm.conf

mdadm --detail --scan --verbose | awk '/ARRAY/ {print}' >> /etc/mdadm/mdadm.conf Обновляем образ initrd:

Для CentOS:

dracut -f -v --regenerate-allДля Debian/Ubuntu:

update-initramfs -u -k allОбновляем конфигурацию GRUB.

Для CentOS:

grub2-mkconfig -o /boot/grub2/grub.cfg

Для Debian/Ubuntu:

update-grubПосле выполненных действий старые диски можно извлекать.

6. Расширение файловой системы (ext4) корневого раздела

Разметка дисков до расширения файловой системы после переноса системы на диски 2 x 3TB (RAID-1).

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

sdb 8:16 0 223,6G 0 disk

sdc 8:32 0 2,7T 0 disk

├─sdc1 8:33 0 2M 0 part

├─sdc2 8:34 0 1G 0 part

│ └─md127 9:127 0 1023M 0 raid1 /boot

└─sdc3 8:35 0 2,7T 0 part

└─md126 9:126 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdd 8:48 0 2,7T 0 disk

├─sdd1 8:49 0 2M 0 part

├─sdd2 8:50 0 1G 0 part

│ └─md127 9:127 0 1023M 0 raid1 /boot

└─sdd3 8:51 0 2,7T 0 part

└─md126 9:126 0 222,4G 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP] Сейчас разделы /dev/sdc3 и /dev/sdd3 занимают 2.7 TB. Так как мы создавали новую разметку дисков с таблицей GPT, то размер 3 раздела был сразу задан на максимально возможное дисковое пространство, расширять раздел в данном случае не требуется.

Необходимо:

- Расширить массив md126,

- Расширить PV (physical volume),

- Расширить LV (logical-volume) vg0-root,

- Расширить файловую систему.

1. Расширяем массив md126 до максимума.

mdadm --grow /dev/md126 --size=max

После расширения массива md126 размер занимаемого пространства увеличился до 2.7 TB.

[root@localhost ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 223,6G 0 disk

sdb 8:16 0 223,6G 0 disk

sdc 8:32 0 2,7T 0 disk

├─sdc1 8:33 0 2M 0 part

├─sdc2 8:34 0 1G 0 part

│ └─md127 9:127 0 1023M 0 raid1 /boot

└─sdc3 8:35 0 2,7T 0 part

└─md126 9:126 0 2,7T 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

sdd 8:48 0 2,7T 0 disk

├─sdd1 8:49 0 2M 0 part

├─sdd2 8:50 0 1G 0 part

│ └─md127 9:127 0 1023M 0 raid1 /boot

└─sdd3 8:51 0 2,7T 0 part

└─md126 9:126 0 2,7T 0 raid1

├─vg0-root 253:0 0 206,4G 0 lvm /

└─vg0-swap 253:1 0 16G 0 lvm [SWAP]

Расширяем physical volume.

Перед расширением проверяем текущее значение занимаемого пространства PV /dev/md126.

[root@localhost ~]# pvs

PV VG Fmt Attr PSize PFree

/dev/md126 vg0 lvm2 a-- 222,40g 0 Расширяем PV следующем командой.

pvresize /dev/md126

Проверяем выполненное действие.

[root@localhost ~]# pvs

PV VG Fmt Attr PSize PFree

/dev/md126 vg0 lvm2 a-- <2,73t 2,51tРасширяем logical volume vg0-root.

После расширения PV проверим занимаемое пространство VG.

[root@localhost ~]# vgs

VG #PV #LV #SN Attr VSize VFree

vg0 1 2 0 wz--n- <2,73t 2,51tПроверим занимаемое LV пространство.

[root@localhost ~]# lvs

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert

root vg0 -wi-ao---- <206,41g

swap vg0 -wi-ao---- <16,00g Том vg0-root занимает 206.41 GB.

Расширяем LV до максимума дискового пространства.

lvextend -l +100%FREE /dev/mapper/vg0-root Проверяем пространство LV после расширения.

[root@localhost ~]# lvs

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert

root vg0 -wi-ao---- 2,71t

swap vg0 -wi-ao---- <16,00gРасширяем файловую систему (ext4).

Проверим текущий размер файловой системы.

[root@localhost ~]# df -h

Файловая система Размер Использовано Дост Использовано% Cмонтировано в

devtmpfs 16G 0 16G 0% /dev

tmpfs 16G 0 16G 0% /dev/shm

tmpfs 16G 9,6M 16G 1% /run

tmpfs 16G 0 16G 0% /sys/fs/cgroup

/dev/mapper/vg0-root 204G 1,4G 192G 1% /

/dev/md127 1007M 141M 816M 15% /boot

tmpfs 3,2G 0 3,2G 0% /run/user/0Том /dev/mapper/vg0-root занимает 204 GB после расширения LV.

Расширяем файловую систему.

resize2fs /dev/mapper/vg0-root

Проверяем размер файловой системы после её расширения.

[root@localhost ~]# df -h

Файловая система Размер Использовано Дост Использовано% Cмонтировано в

devtmpfs 16G 0 16G 0% /dev

tmpfs 16G 0 16G 0% /dev/shm

tmpfs 16G 9,6M 16G 1% /run

tmpfs 16G 0 16G 0% /sys/fs/cgroup

/dev/mapper/vg0-root 2,7T 1,4G 2,6T 1% /

/dev/md127 1007M 141M 816M 15% /boot

tmpfs 3,2G 0 3,2G 0% /run/user/0 Размер файловой системы увеличен на весь объём тома.

Источник: habr.com